Reunión Latinoamericana de Análisis de Redes Sociales

Reunión Latinoamericana de Análisis de Redes Sociales

Redes libres

de escala en ciencias sociales:

Significado y perspectivas

Carlos

Reynoso

UNIVERSIDAD DE BUENOS AIRES

billyreyno@hotmail.com

Versión 2.9 – Marzo de 2008

2 – Especificación epistemológica

4 – Momento fundacional: Teoría de grafos

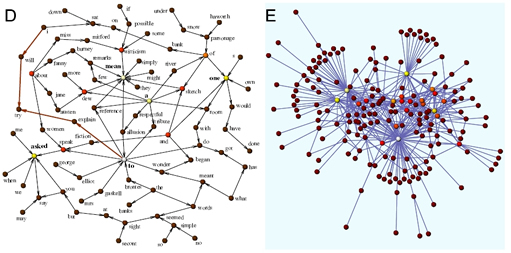

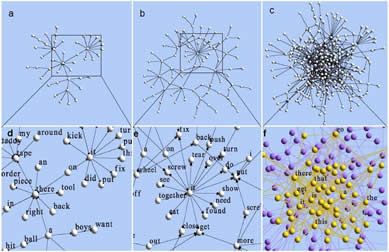

5 – De grafos a redes: La Sociometría y la Escuela de Harvard

6 – Redes aleatorias: Posibilidades y límites del azar

7 – Teorías sociológicas y antropológicas de redes

8 – Análisis micro, análisis macro y la fuerza de los lazos débiles

9 – El advenimiento de los Mundos Pequeños

10 – Encuentro de las redes y la complejidad: Redes libres de escala

11 – Ley de potencia: Los significados de una distribución

12 – Las redes complejas del lenguaje y el texto

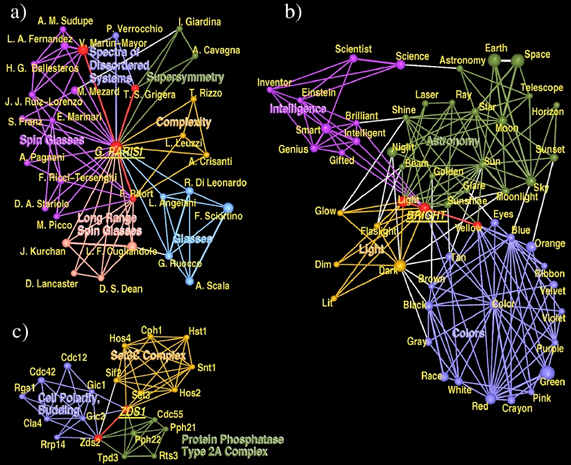

13 – Clases de universalidad y claves para una transdisciplina

14 – Criticalidad auto-organizada y Percolación

15 – Parentesco: Nuevas técnicas reticulares

16 – Alcances y límites de la teoría de redes (y de la complejidad)

Redes

libres de escala en ciencias sociales:

Significado y perspectivas

Carlos Reynoso

UNIVERSIDAD DE BUENOS AIRES

Versión 2.9 – Marzo de 2008

A partir del momento en que los

diversos aspectos

de la vida social (económicos,

lingüísticos, etc)

se expresen como

relaciones, queda abierto

el camino para una antropología

concebida como

una teoría general de

las relaciones, y para un

análisis de las sociedades en

términos de rasgos

diferenciales característicos

de los sistemas

de relaciones que las definen.

Lévi Strauss (1973: 88)

1 – Justificación

En las puertas del siglo XXI las teorías de redes, ya de antigua data en sociología y antropología, devinieron al fin complejas, caóticas, dinámicas y no lineales en el sentido técnico de la palabra. Un encadenamiento de nuevas ideas trajo aparejadas una visión distinta y hasta capacidades impensadas de intervención. Algunos métodos y objetivos imposibles de implementar pocos años antes se volvieron no sólo viables sino moneda común: dar cuenta del cambio complejo y la morfogénesis, disponer de teorías de transiciones de fase y procesos adaptativos, comprender la emergencia, indagar fenómenos sociales de sincronización, definir algoritmos para encontrar comunidades en redes inmensas, tratar analítica y gráficamente estructuras de miles o millones de elementos, pasar de la angustia existencial de la prueba de Gödel a las heurísticas positivas de la teoría de la NP-completitud, disponer de un modelo matemático tratable acorde a las estructuras empíricas, desarrollar heurísticas de trabajo en condiciones de conocimiento incompleto (Garey y Johnson 1979; Bocaletti y otros 2006; Strogatz 2003). En los tiempos que corren están surgiendo teorías reticulares de la evolución y modelos en red de la genómica, de los orígenes de la vida y de la actividad cerebral desvelada por la neurociencia (Bornholdt y Schuster 2003); las redes sociales están definitivamente integradas a las que estudian matemáticos y demás científicos. No es el mejor momento para que una disciplina como la antropología se haga la desentendida y se refugie en su especificidad, menos aún cuando su objeto ha dejado de ser lo que era y el papel de la disciplina en el conjunto de las ciencias (y el monto de la financiación y del respaldo social que merece) está necesitado de una buena justificación.

En consonancia con ese escenario, el objetivo de esta presentación es brindar una visión de conjunto de los aspectos esenciales de las teorías de la complejidad y el caos desde la antropología, tomando como punto de mira el análisis de redes sociales, el cual constituye, esté o no de por medio alguna variedad de paradigma complejo, un tema de interés en ciencias sociales tanto más urgente cuanto mal conocido. No es una introducción a la teoría de redes ni a la de la complejidad, sino más bien un análisis de las consecuencias epistemológicas que emanan del encuentro y de la sinergía de esas dos corrientes.

Dado el carácter dinámico de su objeto, este artículo no es un texto en estado estable sino un trabajo en proceso que se detendrá en algún momento, en el rango de meses o años, cuando alcance iterativa e incrementalmente el formato de un libro, preservando en lo posible la estructura y las proporciones actuales; de allí que lo haya versionado según la nomenclatura que es de uso común en desarrollo de software. En torno de esta estrategia de escritura el trabajo extiende, reformula o corrige, en base a nuevos contenidos, otros ensayos más breves y circunstanciales. Al lado de eso, desarrolla con más sistematicidad que pedagogía las consecuencias disciplinares específicas de una técnica contemporánea que bien podría ser otra (algoritmo genético, modelado basado en agentes, gráficos de recurrencia) pero que aquí serán centralmente las redes. Se aprovechará el trazado de una visión estratégica para identificar una serie de moralejas, desafíos o lecciones epistemológicas acarreadas tanto por la teoría de redes como por la perspectiva compleja, y sobre todo por la complementación de ambas.

De hecho, esa teoría y esta perspectiva se han tornado cada vez más convergentes y puede decirse que juntas han llegado a ser mucho más que la suma de sus partes. En cuanto a las lecciones a las que hice mención, ellas ponen en tela de juicio algunos de los estereotipos y mitos antropológicos y epistemológicos más arraigados, lo cual ofrece alguna utilidad al investigador que se aventure a leer este artículo más allá que adopte o no en el futuro un marco conceptual ligado a la complejidad o a una tecnología reticular.

Como en otros textos de heurística positiva que he escrito en los últimos años, aquí considero que la tecnología es contingente y no un fin en sí misma; pero no por ello es despreciable: de lo que se aprende teoréticamente con su uso no me parece que haya posibilidad de retorno o de negociación. Sobre todo con el advenimiento de posibilidades de modelado antes inéditas, las técnicas ya no son ciudadanos de tercera por debajo del prestigio de las teorías y los métodos, sino elementos de trabajo que bien pueden impactar recursivamente en la teoría o hasta revelar la viabilidad de una línea de razonamiento antes reputada imposible o la intratabilidad de un problema que en el plano teórico parece trivial. La técnica misma, por otro lado, puede constituir un límite, o ponerlo de manifiesto: ciertos procedimientos analíticos e incluso ciertos algoritmos de graficación en geometría computacional conceptualmente requeridos resultan ser duros o imposibles de resolver en tiempo polinómico (Tamassia 1997; 2000: 952-957). Algunas redes, en consecuencia, se pueden concebir intelectualmente (en principio) pero no se podrán visualizar jamás, y también viceversa. Pero mientras tanto el progreso exponencial de las técnicas ha definido un amplio espacio de maniobra, acaso el más amplio y el más difícil que hayamos tenido jamás entre manos, al lado de un inmenso caudal de conceptos pendientes de coordinación con nuestras categorías disciplinares.

En los intersticios de la ejecución de los objetivos antedichos procuraré señalar aquí y allá algunas perspectivas que pasan por ser complejas, pero que no han ofrecido, en décadas, herramientas de parecido nivel de compromiso y potencial de cambio1. La frecuencia y la prioridad de esta demarcación será más bien baja, pues la idea no es articular una crítica sistemática ni dictaminar una zona de exclusión, sino marcar un contraste entre lo que hay y lo que podría haber por poco que uno se aventure más allá del confinamiento intradisciplinario que ha sido la norma en las tres últimas décadas y al que esas doctrinas, con sus discursos clausurados sobre sí mismos, han terminado homologando. También me esforzaré por vincular dos territorios (la vieja teoría de redes manchesteriana y sus derivaciones, y la nueva ciencia de la redes libres de escala) que hasta el día de hoy siguen sin integrarse como debieran.

Entre la cohorte de demostraciones paralelas que acompaña a la ejecución de los objetivos primarios he concedido especial prioridad el señalamiento de importantes posibilidades de innovación que se abren merced a nuevas posibilidades formales. En ciencias sociales (y aquí el ejemplo de Morin es paradigmático) ciertos pensadores hacen hincapié en las posibilidades que se cierran en las ciencias sociales debido a la demostración de determinados teoremas y principios en las ciencias básicas (el teorema de Gödel, la teoría de la relatividad y el principio de indeterminación de Heisenberg a la cabeza); por ningún lado aparecen referencias a las posibilidades que se abren a partir de la demostración de otros teoremas, lemmas y corolarios igualmente importantes y universales.

Insistiré todo el tiempo en la puesta en contexto, significado y valor de las teorías referidas y en la consulta intensiva de los textos originales, antes que en la vulgata esquemática plagada de errores endémicos y de efectos de teléfono descompuesto que se ha enquistado en la comunidad de los especialistas. Trataré de quebrar el tabú implícito que la antropología ha impuesto en torno de las estrategias de redes, que aún cuando se originaron setenta años atrás en las ciencias humanas no han sido jamás referidas en las grandes crónicas históricas de la disciplina. Al ocuparme de ellas no mencionaré ningún libro o artículo en el cual haya algún elemento crucial que no entienda y del cual no tenga copia a la mano aquí y ahora. Aún cuando mi postura pueda definirse a grandes rasgos como de aceptación, registraré por último algunas notas de caución y vigilancia reflexiva ante lo que percibo como la posibilidad de un uso fetichista de las teorías y técnicas del nuevo siglo, tanto en materia de redes como de complejidad; más aún que el rechazo por parte de quienes se resisten a las teorías de redes o de la complejidad, este factor es sin duda el mayor obstáculo a enfrentar.

2 – Especificación epistemológica

En la mayor parte de la literatura de redes sociales y en la casi totalidad de la bibliografía sobre herramientas de complejidad la epistemología acostumbra ser implícita y escuálida; si se toma, por ejemplo, Social Network Analysis, el manual clásico de Stanley Wasserman y Katherine Faust (1994), excelente en el orden técnico, se buscará en vano un par de páginas sobre el particular. No espero que ese sea aquí el caso; tampoco será este ensayo un resumen de los conceptos, algoritmos y magnitudes más importantes, o una introducción a la disciplina. Es sólo un texto de teoría que pone en foco una importante inflexión contemporánea, que intenta evaluar su significación y que entiendo que es necesario que se escriba porque en todo el campo, hasta donde se alcanza a ver, ningún otro se ha hecho cargo de la tarea.

Dado el carácter epistemológicamente complejo y la tesitura crítica y autocrítica del presente trabajo, conviene establecer desde el principio las metodologías y heurísticas que lo orientan. Ellas configuran el aparato reflexivo del estudio y son fundamentalmente de tres clases.

La primera heurística concierne a una tipología de modelos que ya articulé en otros trabajos. Esta tipología, cuyos orígenes se remontan a la idea de complejidad organizada de Warren Weaver (1948), es la que se describe en la tabla 1; la nomenclatura, las propiedades y los propósitos de la clasificación son lo suficientemente claros como para no requerir más comentario. El objetivo de la tipología es demarcar qué clase de resultados cabe esperar de qué clase de modelos (o de qué forma básica de plantear un problema).

Modelo |

Perspectiva del Objeto |

Inferencia |

Propósito |

I. Mecánico |

Simplicidad organizada |

Analítica, deductiva, determinista, cuantificación universal |

Explicación |

II. Estadístico |

Complejidad desorganizada |

Sintética, inductiva, probabilista, cuantificación existencial |

Correlación |

III. Complejo o sistémico |

Complejidad organizada |

Holista o emergente, descriptiva, determinista, cuantificación conforme a modelo |

Descripción estructural o procesual, modelado |

IV. Interpretativo |

Simplicidad desorganizada |

Estética, abductiva, indeterminista, cuantificación individual |

Comprensión |

Tabla 1 – Los cuatro modelos

Dado el carácter epistemológicamente complejo y la tesitura crítica y autocrítica del presente trabajo, conviene establecer desde el principio las metodologías y heurísticas que lo orientan. Ellas configuran el aparato reflexivo del estudio y son fundamentalmente de tres clases.

La primera heurística concierne a una tipología de modelos que ya articulé en otros trabajos. Esta tipología, cuyos orígenes se remontan a la idea de complejidad organizada de Warren Weaver (1948), es la que se describe en la tabla 1; la nomenclatura, las propiedades y los propósitos de la clasificación son lo suficientemente claros como para no requerir más comentario. El objetivo de la tipología es demarcar qué clase de resultados cabe esperar de qué clase de modelos (o de qué forma básica de plantear un problema).

A diferencia de lo que es rutina en las teorías discursivas o ingenuas de la complejidad, lo que aquí llamo perspectiva no deriva de ni se refiere a las características del objeto real, sea ello lo que fuere; mal que le pese a los antropólogos urbanos o a los que han echado su mirada hacia Occidente o hacia la sociedad (pos)moderna, es una ingenuidad creer que hay sociedades o culturas simples o complejas, u órdenes sociales inherentemente más contemporáneos o más multivariados que otros. Simplicidad y complejidad resultan de aplicar escalas, articular variables o definir focos en el plano epistemológico, y no de cualidades dadas en la realidad. Conforme a las inferencias que ellas aplican y al propósito que se han propuesto, casi todas las teorías a revisarse en este paper pertenecen a los tipos que en la tabla llamo I o II; unas pocas, las más recientes, se inclinan hacia el tipo III. No soy partidario de un tipo en detrimento de otros; cada uno de ellos, incluso el tipo IV, puede ser de aplicación preferencial cuando se plantean los problemas de determinada forma o en determinadas inflexiones de un razonamiento heterogéneo; las investigaciones empíricas en la vida real conmutan, combinan o hibridizan los diversos tipos con o sin autoconciencia de estar haciéndolo.

El segundo artefacto que propongo es, como no podría ser de otra manera, una definición de problema. Esta es una criatura conceptual que debería ser de especificación obligatoria en todo texto, pero a la que la epistemología constituida no ha prestado mayor atención. Ni siquiera en la hermenéutica de Hans-Georg Gadamer (1977: 454-455), el primer lugar en el que a uno se le ocurriría buscar, hay el menor rastro de una definición de este tipo. Gadamer especifica cuáles son las propiedades o atributos de un problema: un problema es para él algo que ofende, que choca, que llama la atención; pero no ha definido sustantivamente el concepto. La definición de problema que he hecho mía se origina en la teoría de autómatas y en la tradición de los métodos formales en computación científica: un problema consiste en determinar si una expresión pertenece a un lenguaje (Hopcroft, Motwani y Ullman 2001: 31)2.

Abstracta o metafórica como parece, esta cláusula permite evaluar si una expresión (es decir, un caso) es susceptible de ser engendrada por la gramática y/o el conjunto de constreñimientos del lenguaje que se utiliza, entendiendo por ello la teoría, sus operadores y/o sus métodos aplicados a los datos3. Como las ideas de solución y la jerarquía de la complejidad están también embebidas en la cláusula, ésta permite asimismo determinar si un problema es tratable en la forma en que se lo plantea, definir la escala de proporciones entre la pregunta que se formula y los medios instrumentados para contestarla, orientar el modelo de datos, clarificar la naturaleza y evaluar el ajuste del modelado.

La definición permite dar cabida tanto a los problemas directos como a los inversos. En los primeros las reglas de producción de la expresión ya se conocen; en el segundo se las debe encontrar o construir. De más está decir que los casos de problemas inversos o de inducción (o abducción) gramatical, aunque implícitos como tales, suelen ser mayoría en la ciencia social empírica, desde las formales a las interpretativas: dado un caso, el investigador procura inducir, conjeturar o modelar las reglas o las coerciones que lo generan. Casi todos los problemas que se relacionan con la interpretación de los datos observados son problemas inversos (Bertuglia y Vaio 2005: 12).

Educado en una concepción mecanicista, Jacques Hadamard [1865-1963] consideraba que los problemas inversos son categóricamente problemas mal planteados y que existía una sola solución estable por cada problema (Hadamard 1902; Tarantola 2005). Ya nadie piensa de este modo, pero la distinción entre clases de problemas podría llegar a servir para reflexionar sobre lo que se está haciendo y para definir heurísticas o patrones metodológicos en función de lo que ya se sabe de esas clases. En el ensayo que va a leerse, la definición de problema (directo o inverso) estará siempre activa, como residente en el fondo de la escena, mientras analizo las teorías, describo las propuestas y propongo los instrumentos.

La tercera clase de artefactos es un conjunto de criterios epistemológicos. Más allá de los requisitos obvios de correspondencia con los hechos y de consistencia interna, se aplicarán a lo largo de este ensayo tres principios que han demostrado ser útiles en las prácticas de diagnóstico de mi epistemología forense, por así llamarla. Ellos son:

-

El principio de Nelson Goodman (1972): Nada es parecido o diferente en absoluto, sino con referencia a una escala y a criterios escogidos por quien define los observables. Un corolario de este principio sería el principio de Georg Cantor, que establece que hay más clases de cosas que cosas, aún cuando éstas sean infinitas. En función de estas ideas se puede hacer colapsar metodologías que se creían consagradas, tales como el pensamiento por analogía de Mary Douglas, o el análisis estructural basado en oposiciones binarias. Está claro que cuando se trata de definir si un objeto pertenece a una clase o a otra, es quien articula los criterios que rigen la pregunta el que decide el valor de la respuesta. No sólo la naturaleza de la relación, sino los objetos que se relacionan son relativos al planteo del problema. Como bien dice Rafael Pérez-Taylor (2006: 11, 93-94), aún en la epistemología más materialista los observables no están dados de antemano sino que se construyen.

-

El principio de René Thom (1992): No tiene sentido hablar de fluctuación, de alea, de desorden, de emergencia e incluso de evento, excepto en relación con la descripción epistemológica en cuyo seno esas conductas se manifiestan como tales. Este principio vulnera fatalmente a todas las epistemologías en que se invoca (por ejemplo) el azar como entidad y como causa última. Por supuesto, las cualidades opuestas también aplican: no hay equilibrio, determinismo, orden, reductibilidad o suceso que no dependan (o que no se constituyan en función) de la clase de modelo que se ha construido.

-

El principio de Korzybski/Whitehead/Bateson: La forma de lo que se considera conceptualmente un objeto depende de los procedimientos de mapeado y no tanto de las características del territorio o del dominio disciplinar. Por ejemplo, no hay verdaderamente “bucles” en los sistemas recursivos, ni “pirámides” en las poblaciones, ni “redes” en las relaciones sociales o de parentesco. Si para representar la conducta de esos sistemas se escoge otra forma de representación (por ejemplo, árboles, funciones, reglas, listas recursivas o historias de vida) la noción imaginaria de circularidad, de estructura jerárquica o de grafo conexo se difumina. Del mismo modo, si para representar un sistema se utiliza álgebra de procesos en vez de la lógica usual de objetos y propiedades, ni siquiera en fenómenos reputados complejos se presentan situaciones de emergencia; en un formalismo algebraico casi todos los objetos se avienen a reducirse a las conductas de sus componentes, aunque no necesariamente en términos lineales (Hatcher y Tofts 2004). Por añadidura, algunas formas de representación muy distintas son equivalentes: los grafos y las matrices de adyacencia, los grafos de Ore y los P-Graphs, por ejemplo. Este conjunto de ideas rompe con el esencialismo y amarga la vida de las estrategias en las que se sindica una abstracción o una comodidad nomenclatoria (por ejemplo, “cultura”, incluso “texto”, quizá “red”) como una instancia dotada de verdadera dimensión ontológica y fuerza causal.

La definición de problema, los cuatro tipos modélicos y los tres principios epistémicos están interrelacionados. En el ejercicio de una crítica teórica o en la evaluación reflexiva de un modelo la definición de problema es el criterio estructural y la condición funcional a satisfacer por los demás elementos, a efectos de que una operatoria que ha puesto en blanco todas y cada una de sus decisiones arbitrarias no degenere en subjetividad o constructivismo: la respuesta a establecer por la definición expuesta debe tender a ser sí o no. La prioridad la tiene la resolución del problema; todo lo demás, con sus libertades y libertinajes inherentes, ha de ser instrumental a ese objetivo.

Estas ideas pueden resultar abstractas ahora pero se ilustrarán suficientemente, espero, en el abordaje crítico y metacrítico de las teorías de redes y complejidad que comienzan a examinarse ahora.

3 – Redes, una vez más

Predigo que en un futuro no muy

distante la gente

en la vida académica se definirá no

por una

sola área de especialización,

sino por dos

sub-especializaciones que pertenecen

a dos

especialidades más bien diferentes. Esto significa

que tendremos una red de intereses en la cual

cada persona servirá

como un puente entre distintas

partes de la estructura

general. Pueden ver que

esto es mucho mejor que tener una jerarquía

en

árbol que se ramifica y ramifica, sin que haya

nadie capaz de hablar con la gente en otras

sub-ramas. Tendremos

personas que pertenezcan

a dos áreas, en dos

partes diferentes de la estructura

global. Ellas serán

entonces capaces de afrontar

el nuevo

conocimiento a medida que sobrevenga.

Donald Knuth, Things a Computer Scientist Rarely Talks About (1999)

Se me ocurren muy pocos asuntos de posible interés en antropología cultural (y casi ninguno en antropología social) que no admitan ser tratados en términos de redes, es decir, en términos de elementos y relaciones entre ellos. Podría pensarse que los conceptos subyacentes a la teoría de redes guardan fuerte relación con principios algo más familiares para los antropólogos como lo son los del estructuralismo, y en particular con la idea estructuralista de sistema, que se define casi de la misma manera. Melvin Whitten y Alvin Wolfe (1973: 719) han advertido esa analogía profunda: “En la década de 1940 –escriben– los penetrantes análisis de [Meyer] Fortes [...] y de [Claude] Lévi-Strauss [...], diferentes como ellos lo son, pusieron tanto énfasis en las intrincaciones de las relaciones socioestructurales que alguna vislumbre de teoría de redes se puede discernir en ellos”.

Tan pujante ha sido el modelo de redes en campos como la sociología económica o el modelado sociológico que en esas disciplinas, que no han poseído en su momento a un Lévi-Strauss o conocido un período estructuralista, la metodología constituye el tronco de lo que se ha llamado sociología estructural (Berkowitz 1982; Swedberg 2000). Mientras el estructuralismo languidece en la antropología desde los setenta, Cambridge University Press sostiene desde 1986 una colección de referencia, Structural Analysis in the Social Sciences, dirigida por Mark Granovetter, un teórico mayor que nos ocupará más adelante. Pero a despecho de los nombres que se utilicen en otras disciplinas, el análisis de redes y el estructuralismo no son la misma cosa. Por empezar, la teoría de redes ha sido más cauta que el estructuralismo en muchos respectos; un buen teórico de redes, por ejemplo, nunca afirmaría que toda red califique como sistema sólo por estar constituida como lo está. Y esta es una precaución a tener en cuenta: el hecho de poder representar un conjunto de relaciones como si fuera una red no establece su carácter sistemático ni promueve la indagación a un plano superior de complejidad.

Elementos y relaciones, estaba diciendo. Desde el punto de vista semántico los elementos pueden ser cualesquiera (personas, grupos, instituciones, moléculas, piezas de música, palabras, países) y los vínculos también (relaciones de conocimiento, transacciones comerciales, influencia, afinidad, contagio, derivación, violencia, poder, tráfico, relaciones sintagmáticas, clientelismo y por supuesto alianza, filiación y consanguinidad); estos vínculos pueden ser además meramente nominales o finamente cuantitativos. El objetivo del análisis de redes es obtener a partir de los datos relacionales de bajo nivel una descripción de alto nivel de la estructura del conjunto.

Los modelos pueden ser tanto estáticos como dinámicos, tanto topológicos como dimensionales, tanto axiomáticos como exploratorios. Aunque se han creado infinidad de medidas (de centralidad de grado, de proximidad, de betweenness; de conglomerado, de conectividad, de diámetro, de cohesión) la teoría de redes no es simplemente cuantitativa; las cuantificaciones de la teoría de redes son menos excursiones en una aritmética envolvente que evaluaciones de la mayor o menor pregnancia de cualidades sumamente expresivas. La representación basada en la metáfora de las redes de ningún modo es más “artificial” que el tratamiento discursivo de una realidad; un poco más abstracto y bastante más visual puede ser, pero no mucho más que eso. En todo caso, la metáfora es tentadora: en una ciencia compleja, la estructura de numerosos modelos de la cosa real puede ser, en ocasiones, algo que podemos pensar en algunos respectos como si se tratara de una red.

Como formalismo, la teoría de redes posee una cualidad analógica que la hace particularmente útil e inteligible en ciencias sociales, a juicio de algunos más aún que (por ejemplo) los modelos de simulación. De éstos se ha llegado a decir que deben utilizarse sólo como último recurso allí donde los métodos analíticos han probado ser intratables (Friedkin 2003). El estudio de redes constituye uno de esos métodos analíticos, una especie de modelado down to top que permite pasar de los niveles individuales a las agrupaciones colectivas menos conflictivamente que otros formalismos. Y sí, a veces puede suceder que los modelos planteados sean intratables y haya que intentar otras tácticas. También sucede que el objeto de un modelo de simulación bien podría ser el comportamiento dinámico de una red; y muchas veces se da el caso que las diversas clases de modelos se pueden combinar, algo que en el ambiente de las ciencias complejas está pasando cada vez con mayor asiduidad (Barabási 2003; Amaral y Ottino 2004; Mitchell 2006).

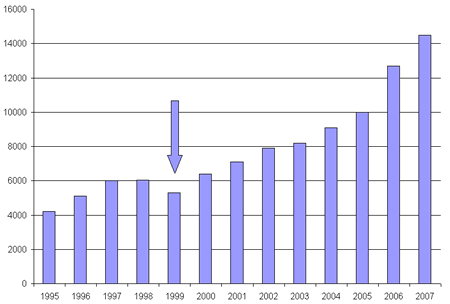

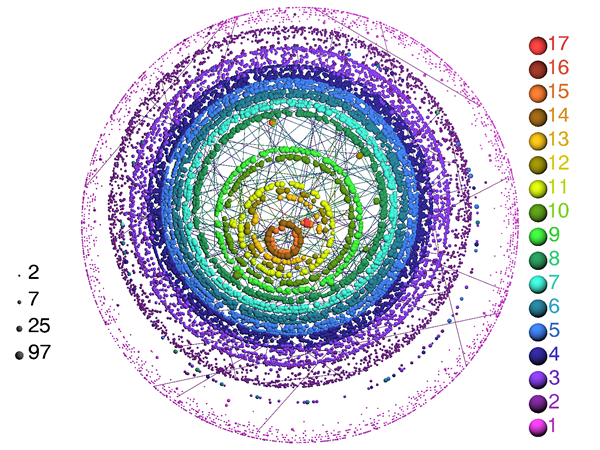

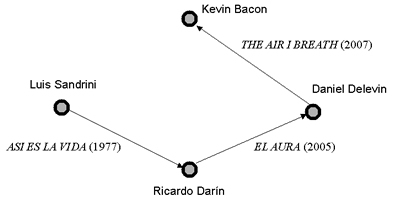

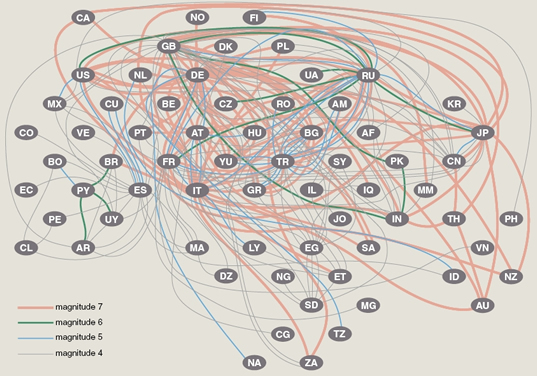

El impulso que las teorías de la dinámica no lineal y la complejidad infundieron al análisis de redes puede inferirse de las estadísticas de PubMed (www.pubmed.com) de los últimos años. La figura 1 muestra las cifras correspondientes a artículos que incluyen los nomencladores “network” o “networks” en sus títulos o palabras claves. A comienzos del período contemplado hay un ciclo de crecimiento moderado a caballo de esa Biblia de las formas clásicas del ARS que es el manual de Wasserman y Faust (1994); el punto de inflexión, señalado con una flecha, corresponde al momento de la publicación de los artículos fundamentales de Watts y Strogatz (1998) y Barabási y Albert (1999) y al lanzamiento del programa Ucinet (Borgatti y otros 2002). Duele decirlo, pero al menos en este sistema de indexación en los últimos 4 o 5 años los trabajos sobre redes exceden a los de toda la antropología en su conjunto, la cual no está por cierto experimentando crecimiento alguno de unas décadas a esta parte.

Figura 1 – Artículos académicos sobre redes en PubMed (Csermely 2006: 6)

En tanto modelo, el formalismo de redes selecciona ciertos aspectos de la realidad y deja de lado otros, pero en esto no hay diferencia entre un tratamiento modelado y otro discursivo. Aún cuando cualitativistas y hermeneutas dejen a veces trasuntar lo contrario, no existen formas naturales de tratar una cuestión; tampoco las hay que sean más humanas o humanizadoras que otras, o que sólo por promover un estilo metodológico o una forma de expresión garanticen ser más profundas, completas, concretas o mejores. En las técnicas de modelado reticulares, igual que en otras clases de modelos, la idea no es reproducir las propiedades de un fenómeno complejo hasta los detalles más mínimos, sino proporcionar resultados acordes con las suposiciones realizadas, permitiéndonos tratar con las implicancias de nuestras opiniones. Si decimos que las relaciones entre sujetos, agentes, actores o lo que fuere tienen tales o cuales características, la analítica de redes permite afrontar algunas consecuencias probables, y en ocasiones deterministas, que se siguen de lo que se postula. Que el vocabulario descriptivo, la semántica de los functores, la emergente lógica espacial de la representación (cf. Aiello, Pratt-Hartmann y van Benthem 2007) y demás elementos del planteo sean públicos –aunque no unánimes– añade otra instancia más de reflexividad.

4 – Momento fundacional: Teoría de grafos

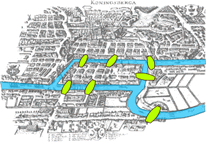

La historia de la teoría de las redes sociales se remonta a los orígenes de la teoría de grafos en matemáticas, creada hacia 1736 por el suizo Leonhard Euler [1707-1783]. Este matemático prodigioso, uno de los escritores más prolíficos de la historia, inventó de la noche a la mañana la teoría de grafos al resolver el famoso problema de los siete puentes sobre el río Pregel en Königsberg, la ciudad que hoy se llama Kaliningrado4.

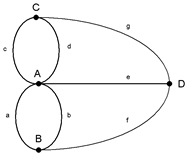

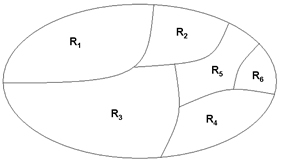

El problema consistía en averiguar si se puede pasar por los siete puentes sin cruzar más de una vez por cada uno de ellos. En su planteamiento, lo que hizo Euler fue como lo que siempre hizo el antropólogo Clifford Geertz sólo que al revés: generalizar el problema. Para ello eliminó de cuajo toda información irrelevante al cálculo de la solución, dejando sólo las masas de tierra, representadas por un punto, vértice o nodo, y los puentes mismos, concebidos como líneas, aristas, bordes o vínculos. La inclinación y longitud de los trazos tampoco son tomadas en consideración. El grafo abstraído por él es lo que hoy se conoce como un multigrafo, un grafo que admite más de un vínculo por vértice. Una red es por cierto una clase de grafo o, formalmente, la interpretación de un grafo (Ore 1962: 2; Bondy y Murty 1976; Harary 1969; Wilson 2004).

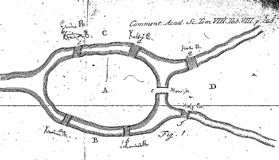

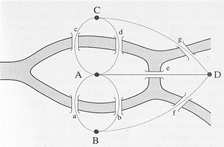

Figura 2 – Los puentes de Königsberg/Kaliningrado y su serie de abstracciones

De hecho, Euler ni siquiera dibujó un grafo en el trámite de su prueba ni mencionó tampoco esa palabra, que recién fue introducida por James Joseph Sylvester en 1878. Euler llamó grado al número de vértices que convergen en un nodo. La solución solamente considera la distribución de grados en los vértices. El grafo propiamente dicho, ilustrado en la parte inferior de la figura 2 con su notación originaria, fue trazado por vez primera por el matemático inglés Walter William Rouse Ball (1892) a fines del siglo XIX.

Euler encontró que la pregunta formulada en el problema de los puentes de Königsberg debía responderse por la negativa. Definió para ello dos conceptos:

-

Se dice que un grafo tiene un camino de Euler si se pueden trazar arcos sin levantar la pluma y sin dibujar más de una vez cada arco.

-

Un circuito de Euler obedece a la misma prescripción, con la exigencia agregada de finalizar en el mismo nodo en que se comenzó. Todos los circuitos son caminos eulerianos.

Y Euler halló que:

-

Un grafo con todos los vértices pares contiene un circuito de Euler, sea cual fuere su topología.

-

Un grafo con dos vértices impares y algunos otros pares contiene un camino de Euler.

Un grafo con más de dos vértices impares no contiene ningún camino y tampoco contiene ningún circuito de Euler. Siendo que en el caso de los puentes hay tres nodos de grado 3 y uno de grado 5, no hay ningún camino de Euler entre ellos. La lección para los científicos sociales, imbuidos de extremismo idiográfico de un siglo a esta parte, es que estas soluciones son universales y permanentes por cuanto derivan de propiedades inherentes a los respectivos tipos de grafos; no vale la pena pasar noches en vela intentando hallar soluciones alternativas, porque no las hay. En el deslinde de estas propiedades topológicas finca precisamente el origen y el espíritu de la moderna teoría de redes.

Figura 3 – Kaliningrado, ca. 1995 – El puente entre A y B

De Euler en más (luego de un silencio de más de un siglo) se ha derivado la teoría de grafos, cuyo trámite histórico pasaremos por alto. Basta decir que en ella se distinguen varios estilos y tradiciones, con participación destacada de una escuela húngara (König, Erdös, Rényi, Turán, Gallai, Hajós, Bollobás) que continuará luego en el ámbito aplicativo de las redes, sociales y de las otras (Barabási, Vicsek). Pese a su carácter abstracto, la especialidad que se conoce como la teoría matemática de los hipergrafos, con sus cliques, matroides, árboles y ciclos, ha trabajado en relación con aplicaciones operativas en diversas disciplinas, las redes sociales entre ellas. El concepto de clique, por ejemplo, acuñado en sociología y psicología de grupo, ha ingresado en la terminología matemática formal vinculada a los hipergrafos (Berge 1991: 76, 146, 176; Erdös 1973: 361-362). Las disciplinas empíricas constantemente presentan a las matemáticas problemas de aplicación de los más diversos que, como los puentes de Königsberg, mantienen viva la oferta y la demanda de conjeturas, descubrimientos y pruebas formales. No se trata tanto de que a los matemáticos les interesen los desarrollos aplicativos, sino al hecho de que en la investigación empírica se definen constantemente problemas formales de relevancia que toca a los matemáticos resolver. Si no hubiera surgido el juego de ingenio de caminar por los puentes de Königsberg siguiendo ciertas reglas, tal vez nunca nadie habría pensado que para su resolución conviene pensar en algo tan improbable como un grafo.

Consecuencia n° 1: La moraleja epistemológica a sacar de este primer punto en el tratamiento de la teoría de redes es que al menos unos cuantos problemas de la investigación empírica en ciencias sociales podrían abordarse (si es que no resolverse) en función de las propiedades universales de la topología o de la estructura conceptual del fenómeno, antes que en función de los detalles contingentes del caso en particular. Decía Geertz en “Persona, tiempo y conducta en Bali”, escrito en 1966:

En cualquier sociedad, el número de estructuras culturales en general aceptadas y frecuentemente usadas es extremadamente grande, de manera que discernir aún las más importantes y establecer las relaciones que pudieran tener entre sí es una tarea analítica considerable. Pero la tarea se ve algún tanto aligerada por el hecho de que ciertas clases de estructuras y ciertas clases de relaciones entre ellas se repiten de una sociedad a otra por la sencilla razón de que las exigencias de orientación a que sirven son genéricamente humanas (1987: 301)

Por una vez, el futuro creador del enfoque hermenéutico, con quien casi nunca estoy de acuerdo, ha sabido poner en dedo en la llaga y señalar un criterioso argumento universalista, aunque a su razonamiento puede que le falte una vuelta de tuerca. Cuando él dice que “ciertas clases de estructuras o relaciones” poseen “exigencias de orientación” universales, ello puede suceder no sólo porque ellas sean genéricamente humanas, sino porque resultan congénitos a la naturaleza formal del problema, la cual puede que no implique “una sencilla razón” sino algo bastante más complejo que eso. Que yo haya escogido mi ejemplo de entre las ideas geertzianas no es casual. Lo que pretendo señalar es que en ellas, igual que en otras elaboraciones interpretativas, está faltando una inspección genuina de la naturaleza hermenéutica del problema y de la lógica de la clase de preguntas que en función de esa naturaleza corresponde hacer.

A lo que voy en esta primera lección es al hecho de que aún una leve reflexión sistemática sobre los constreñimientos estructurales de un problema ayudaría a evitar falacias recurrentes de la investigación sociocultural. No se necesita echar mano de teoría de redes de última generación para soslayar lo que Jorge Miceli, tomando la idea de la arquitectura de software, ha sugerido llamar “antipatrones” del razonamiento antropológico, pero mi conjetura apunta en esa dirección. Tres breves ejemplos de señalamiento de inferencias incorrectas formalmente evitables vienen aquí a cuento: el principio de Condorcet, el teorema de la imposibilidad de Arrow y la falacia de la personalidad modal de las escuelas de Cultura y Personalidad.

-

El principio de Condorcet se manifiesta en sistemas de votación muy simples y poco numerosos en los cuales se establece como condición que cada votante exprese sus preferencias mediante un rango. En una situación con tres votantes (A, B y C) y tres candidatos (x, y, z), si A elige x-y-z, B escoge y-z-x, mientras C prefiere z-x-y, no se podría generalizar un orden de preferencia, porque x derrota a y por 2 a 1, y vence a z por la misma cantidad y lo mismo sucede con z y x (Blair y Pollack 1999). La paradoja de piedra-papel-tijera (el dilema del prisionero, en último análisis) aparecen en la problemática social con acerba recurrencia.

-

El teorema del Premio Nóbel Kenneth Arrow (uno de los más distorsionados por lecturas simplistas después del teorema de Gödel) también tiene que ver con mecanismos de votación, o sea que presenta un problema de decisión. Lo que el teorema demuestra no es que no se puede pasar de lo individual a lo general, sino que ningún mecanismo de votación colectivo puede cumplir simultáneamente con un conjunto acotado de condiciones (no-dictadura, universalidad, independencia de alternativas irrelevantes [IAI], monotonicidad, soberanía del ciudadano, eficiencia de Pareto). Lo que Arrow quiere decir con esto es que un mecanismo de votación es no lineal y no trivial y que para predecir un resultado se debe utilizar necesariamente teoría de juegos o un modelo de simulación. Por último, y según lo ha probado teoremáticamente Edward McNeal discutiendo el problema de “cuál es la mejor ciudad para vivir”, la condición de IAI (que impide crear una medida escalar homogénea a partir de diferentes categorías inconmensurables o sensibles al contexto) impediría por ejemplo llevar a la práctica el modelo de grilla y grupo de la antropóloga Mary Douglas (Arrow 1950; McNeal 1994).

-

El concepto abstracto del “hombre promedio” de Adolphe Quetelet [1796-1874] y la “personalidad modal” de la vieja antropología psicológica son también expresiones sistemáticamente engañosas, como diría Gilbert Ryle. Muchas veces hablamos de un americano típico, un Tchambuli característico, un Kwakiutl representativo, y construimos esa tipicidad en base a los valores intermedios de un conjunto de variables. Pero una persona construida de ese modo puede no corresponder a ningún caso real y ser una construcción intelectual simplemente ultrajante; si tomamos, por ejemplo, un conjunto de triángulos rectángulos de distintas longitudes de lados, está claro que el triángulo que resulta de la media aritmética de cada uno de los lados y de la hipoteunsa no satisface el teorema de Pitágoras; lo mismo se aplica, más dramáticamente, a los perfiles de personalidad (Bertuglia y Vaio 2005: 7). Una vez más mi alusión a Gilbert Ryle (filósofo favorito de Clifford Geertz) no es accidental; la objeción que he señalado (similar a la falacia ecológica) viene a cuento cuando uno, por ejemplo, generaliza lo que se sabe de unos pocos a “los balineses” en general. Hay desde ya generalizaciones legítimas (pasar del caso singular a la forma del problema, por ejemplo); pero ésta en particular, en la que curiosamente incurren todos los particularistas, no lo es.

En una palabra, si logramos articular un problema de modo que tenga una estructura de propiedades bien conocida, en muchos casos es posible determinar a priori qué clase de soluciones admite, o si no admite ninguna, o si las que admite son duras de tratar. Aunque en apariencia nos hayamos alejado del centro de la cuestión, el análisis de redes sociales (por la tortuosa vía de la teoría de grafos) alumbra con especial claridad las problemáticas de constreñimiento estructural.

Consecuencia nº 2: El corolario más fuerte de la lección de Euler testimonia y exalta la capacidad profundamente humana de la abstracción. Esta tesitura es contraria a la que encontramos en el ya aludido conocimiento local geertziano, en la esfera del conocimiento específico de dominio de varias disciplinas contemporáneas y sobre todo en la resistencia a la abstracción por parte de, por ejemplo, Edgar Morin, quien por un lado cuestiona la hiper-especialización y por el otro sostiene que las ideas generales son ideas huecas y que toda abstracción es mutilante (Morin 1998: 231; 2003: 142). Si algo se aprende con la experiencia de modelado es que las estrategias que denigran la abstracción falsean el hecho que ésta es inevitable: cuando ellas abordan discursivamente un fenómeno, pasan por alto que siempre se está imponiendo a la singularidad de lo concreto el molde arbitrario de las abstracciones de un lenguaje de propósito general, independiente de objeto, contingentemente tipificado. No hay más distorsión en un modelado basado en redes que en una narrativa que trata de embutir la realidad en la jaula del lenguaje. La teoría de grafos y redes no niega ni afirma la legitimidad de otras aproximaciones que alegan ser o que acaso sean más concretas; simplemente destaca nuevas posibilidades de entendimiento basadas en un estilo de abstracción entre los muchos posibles.

5 – De grafos a redes: La Sociometría y la Escuela de Harvard

Si esta fuera una historia lineal del pensamiento reticular diríamos ahora que en la década de 1930 un alumno de Gustav Jung, Jacob Levy Moreno [1889-1974], inventó, fundando un campo que él llamo sociometría, algunos formalismos para representar relaciones sociales: sociomatrices y sociogramas. Levy Moreno fue, para decir lo menos, un personaje curioso que creó además el role playing y el psicodrama; admirado por unos y denostado por otros, se lo considera un pensador extravagante y poco digno de confianza, aunque su idea de vincular los grafos matemáticos con las problemáticas sociales haya sido una intuición genial por donde se la mire.

Hoy cuesta apreciar la magnitud de su aporte, pero no hay duda que fue sustancial: la sociedad no es un agregado de individuos con sus características, como argüían los estadísticos, sino una estructura de vínculos interpersonales, pensaba Moreno. Más allá de su aparente obviedad, la idea de sociograma no se agota en una representación, sino que explota con inteligencia el hecho de que, al margen de las herramientas de cálculo de las que se disponga, la visión humana está adaptada especialmente al reconocimiento de patrones. No se trata sólo de la vieja leyenda que reza que “una imagen vale más que cien palabras”, una media verdad que depende de cuáles son las imágenes y cuáles las palabras que están en juego; no es en este campo del conocimiento donde mejor prolifera esta clase de lugares comunes.

De lo que se trata es del hecho de mucho mayor alcance de las facultades gestálticas, sincrónicas y sintéticas de la visión, capaz de percibir organizaciones imposibles de captar con igual contundencia a través del análisis, el lenguaje o (una vez más) la interpretación. Los primeros sociogramas de Moreno, que se remontan a comienzos de la década de 1930, estaban obviamente dibujados a mano. Sin embargo, en 1934 él ya hablaba en su Who shall survive? de análisis exploratorio, visualización y análisis estructural, términos que ganarían estado público mucho más tarde.

Primero tenemos que visualizar. [...] Los sociómetras han desarrollado un proceso de graficación, el sociograma, que es más que meramente un método de representación. Primero que nada es un método de exploración. Hace posible la exploración de hechos sociométricos. La ubicación apropiada de cada individuo y de todas las interrelaciones de individuos se puede mostrar en un sociograma. Al presente es el único esquema disponible que posibilita el análisis estructural de una comunidad (1953: 95-96).

Moreno introdujo al menos cinco ideas claves en la construcción de imágenes de redes sociales: (1) dibujó grafos; (2) dibujó luego grafos dirigidos; (3) utilizó colores para trazar multigrafos; (4) varió las formas de los puntos para comunicar características de los actores sociales; y (5) mostró que las variaciones en la ubicación de los puntos podía usarse para subrayar importantes rasgos estructurales de los datos (Freeman 2000).

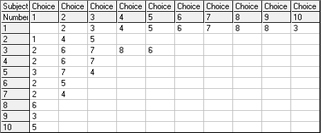

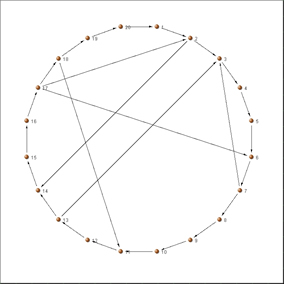

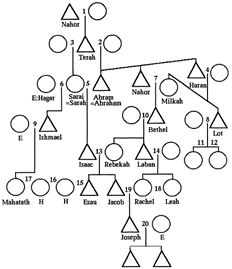

Figura 4 – Sociomatriz, sociograma correspondiente y sociograma autógrafo de Moreno

La figura 4, realizada con el programa Adit Sociogram®, muestra una sociomatriz y su sociograma correspondiente, al lado de uno de los sociogramas autógrafos más tempranos que se conocen (Moreno 1932: 101). Como sea, Granovetter (1973: 1360) afirma que, encerrada en la psicología social en la que se originó, la sociometría no encontró el camino hacia la sociología; le faltaban las técnicas de medición y muestreo para pasar del nivel del pequeño grupo (un poco más arriba del individualismo metodológico) al plano de las estructuras mayores que haría suyo la Gran Teoría.

A instancias de su colaboradora Helen Hall Jennings, en un estudio ulterior publicado en el primer volumen de Sociometry Moreno recurrió al asesoramiento del entonces joven matemático y sociólogo Paul Lazarsfeld [1901-1976]. Esta colaboración resultó en el primer modelo de decisión sociométrico, un modelo probabilístico de un nivel de refinamiento matemático notable para la época (Moreno y Jennings 1938). Próximo a Robert Merton, Lazarsfeld se convertiría con los años en uno de los mayores teóricos de la comunicación de masas; no obstante, sus trabajos no llevan mayormente huellas de los métodos de Moreno y es obvio que en algún momento ambos se distanciaron. En una hipótesis diferente a la de Granovetter, Linton Freeman (2004: 42), uno de los más laboriosos historiadores de la SNA, afirma que la afición de Moreno al misticismo, su estilo personal bombástico y su megalomanía le enajenaron la confianza de sus tempranos partidarios e impidieron que la sociometría hiciera pie en la corriente principal sociológica.

El primer gran estudio que he podido localizar que hace uso de métodos sociogramáticos es el clásico de los psicólogos industriales Fritz Roethlisberger y William J. Dickson (1939) sobre las investigaciones en la famosa factoría Hawthorne de la Western Electric en Cicero, Illinois, entre 1927 y 1933. Hawthorne fue un proyecto enorme, impulsado por el fundador del Movimiento de Relaciones Humanas, el australiano Elton Mayo [1880-1949]; renombrado pero mal conocido, constituye la fuente primordial que sirvió años más tarde a Henry Landsberger (1958) para acuñar la expresión “efecto Hawthorne”, esto es, la forma en que la investigación (y en antropología podríamos decir el trabajo de campo en particular) afecta el comportamiento de los sujetos investigados; una definición alternativa es que los participantes de un experimento se comportan distinto si saben que están en una situación experimental. Hay otros nombres que han aplicado a lo mismo o a cosas parecidas: sesgo sistémico, inducción del observador, realimentación epistémica, efecto del experimentador, factores subjetivos, efecto Pigmalión.

El efecto Hawthorne, glorificado por algunos y vilipendiado por otros, forma parte de la espesa mitografía de la psicología social y los estudios de motivación en administración de empresas. Los hechos que llevaron a él funcionan como una pantalla proyectiva donde algunos ven simples errores de diseño investigativo y otros un mecanismo de incertidumbre sólo comparable al que impera en el mundo cuántico, capaz de inhibir todo examen formal en ciencias sociales. El asunto es delicado y no pienso que se pueda resolver la disputa en un párrafo cargado de ironías a favor o en contra. Pero la relación entre un diseño investigativo con eventual elicitación de sociogramas y el polémico efecto es en todo caso muy tenue; para mal o para bien, la existencia y naturaleza del efecto mismo ha sido puesta una y otra vez en tela de juicio (Kolata 1998)5.

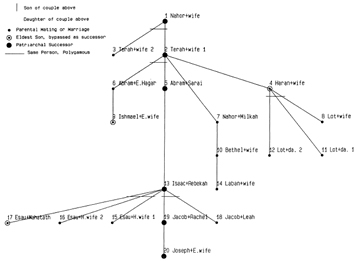

Aunque hacía uso abundante de sociogramas y sociometría, el Movimiento de Relaciones Humanas (y en general la Harvard Business School) no se reconocía tributario de Moreno; sus modelos reticulares fueron elaborados más bien por un antropólogo que había sido discípulo de Radcliffe-Brown en Australia, William Lloyd Warner [1898-1970]. Fue Warner quien convirtió los diseños de investigación de Elton Mayo en estudios de relaciones entre individuos o grupos; también desarrolló las metodologías de proyectos importantes, como los de Deep South, Yankee City y por supuesto Hawthorne. Tanto Warner como Mayo consideraban que sus estudios de grupos constitutían aplicaciones de los modelos estructurales de Radcliffe-Brown. Otras influencias fuertes en la obra de Warner han sido Vilfredo Pareto y Georg Simmel. Suele ignorarse que Warner (1931) fue quien proveyó a Claude Lévi-Strauss los datos sobre la sociedad Murngin explorados en Las estructuras elementales del parentesco; estos datos sirvieron al matemático André Weil [1906-1998], el líder del grupo Bourbaki, para su famoso modelo algebraico (Lévi Strauss 1985: 157, 278-286; Weil 1985).

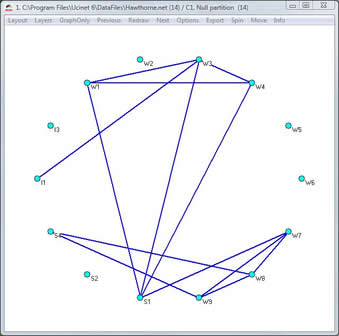

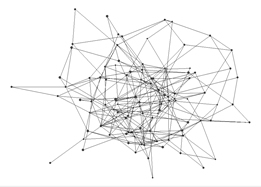

Figura 5 – Sociograma de la factoría Hawthorne

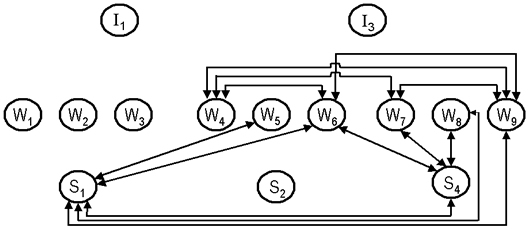

De los relevamientos correspondientes a los modelos de Lloyd Warner he tomado los datos para trazar la figura 5, dibujada setenta años después del estudio original usando el programa Pajek. La figura 6, por su lado, se basa en el grafo original que modela la participación de trabajadores (W), soldadores (S) e inspectores (I) en sus discusiones sobre las ventanas de la instalación. Llamo la atención sobre el hecho de que en aquel entonces no existía aún un desarrollo consistente de la teoría de grafos, ni se había fundado el análisis de redes sociales.

También fueron dos jóvenes antropólogos, Conrad Arensberg [1910-1997] y Eliot Chapple, salidos del riñón del proyecto Yankee City, quienes aportaron mediciones formales de la interacción y diversas herramientas matemáticas para analizar las ingentes masas de datos recabados en los estudios de Harvard. Chapple (1940) llegó a construir una máquina de escribir especial, llamada “cronógrafo de interacción” para registrar las interacciones mediante observación directa en una especie de rollo de pianola. Tal parece que era un aparato descomunal, impráctico para llevar de campaña, pero que se podía usar en factorías para hacer registros en tiempo real, a medida que la gente interactuaba. En su segundo trabajo importante sobre el tema, Chapple (1953) utiliza explícitamente el concepto de análisis de redes (Freeman 2004: 63). La concepción de Chapple todavía involucraba una extrapolación fisicista; él escribía: “podemos, de hecho, usar una forma modificada de la clase de análisis de redes utilizada en electricidad [...] y podemos determinar los efectos de cualquier cambio en los valores cuantitativos asignados a cualquier vínculo sobre sus vecinos en el patrón reticular” (1953: 304).

Figura 6 – Grafo del proyecto Hawthorne (fig. 40 del original)

Una continuación de la sociometría de Moreno de vida relativamente breve fue el programa del Laboratorio de Redes del Instituto Tecnológico de Massachusetts (MIT) conducido por el moreniano Alexander Bavelas desde 1948. El Laboratorio formaba parte del Centro de Investigaciones de Dinámica de Grupos dirigido por el entonces prestigioso Kurt Lewin. Junto a Bavelas, apenas graduado entonces, trabajaban Leon Festinger [1919-1989] y Dorwin Cartwright. Festinger sería luego el creador de la teoría de la disonancia cognitiva, una de las piezas fuertes de la psicología social. Todos los miembros del Lab en el MIT en algún momento ejercieron también influencia en la Escuela de Harvard; ambas instituciones están relativamente próximas en la ciudad de Cambridge, Massachusetts. En este cruzamiento la tradición conservadora de Harvard se benefició del aura de vanguardia del MIT, el cual a su vez recibió algo del prestigio aristocrático de la universidad más vieja de las ocho que forman la rancia Ivy League6.

Bavelas, quien había contratado a R. Duncan Luce como su “matemático cautivo”, desarrolló antes que nadie estadísticas de centralidad que todavía integran el repertorio analítico de los principales modelos y de los paquetes de software más utilizados. Bajo guisas muy diferentes, elaborado y vuelto a elaborar una y otra vez, la centralidad es uno de los conceptos fundamentales del análisis de redes y uno de los que mapean con mayores consecuencias las semánticas y magnitudes de las matemáticas sobre las de la sociología y viceversa. Bavelas (1948; 1950) lo utilizaba para explicar el rendimiento diferencial de las redes de comunicación y de los miembros de una red respecto de variables tales como tiempo para resolver problemas, percepción de liderazgo, eficiencia, satisfacción laboral y cantidad de errores cometidos. Desde entonces se ha echado mano de la centralidad como cálculo esencial para afrontar temas de influencia en redes interorganizacionales, poder, posiciones de ventaja en redes de intercambio, oportunidades de empleo, adopción de innovaciones, fusiones corporativas, tasas diferenciales de crecimiento en ciudades y muchos otros (Borgatti y Everett 2006). El único consenso en torno de la categoría es que se trata de una construcción analítica a nivel de nodo. A partir de allí, la centralidad se divide en tres grandes formas de medida: centralidad de grado, de cercanía [closeness] y de betweenness.

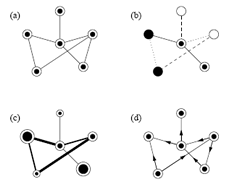

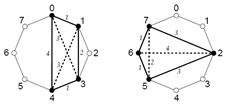

Al lado de sus aportes estadísticos, Bavelas estabilizó las entonces precarias formas de representación gráfica. En su “modelo matemático para el estudio de las estructuras de grupo”, inscripto en la psicología social y en la antropología aplicada, Bavelas (1948) tuvo la intuición de cambiar la perspectiva geométrica de los mapas de la teoría de campo de Lewin (figura 7, izquierda) por grafos topológicos en los que sólo cuentan las relaciones de vecindad entre las regiones (ídem, derecha). Ese fue un paso más hacia una mayor abstracción y universalidad. Bavelas también generalizó la semántica representacional, confiriéndole la estructura que se conserva hasta hoy.

Figura 7 – Mapa lewiniano y grafo de Bavelas correspondiente

En el plano metateórico, los desarrollos de Bavelas contribuyen a que se puedan comprender mejor las raíces gestálticas de la teoría de campo de Kurt Lewin y los intereses casi emic que lo motivaban; con esta base se puede luego entender más cabalmente la dimensión gestáltica subyacente al régimen visual de la teoría de grafos. Escribe Bavelas:

En la época de la primera guerra mundial los psicólogos en Alemania se escindían aproximadamente en estos dos campos: un grupo seguía la senda de desintegrar la persona y la situación en elementos e intentaba explicar el comportamiento en función de relaciones causales simples. El otro grupo intentaba explicar el comportamiento como una función de grupos de factores que constituían un todo dinámico, el campo psicológico. Dicho campo consistía esencialmente en la persona misma y su medio tal como ésta lo veía. Al plantearlo en estos términos ya no se concebía el problema como un problema de relaciones entre elementos aislados sino en función del interjuego dinámico de todos los factores de la situación.

En ese momento Kurt Lewin empezó a formular un método para el análisis de las situaciones psicológicas que tenía como base el volverlas a enunciar en términos matemáticos: la geometría para la expresión de las relaciones en posición entre las partes del espacio vital, y los vectores para la expresión de la fuerza, dirección y punto de aplicación de las fuerzas psicológicas. El uso de la geometría era natural en un enfoque psicológico que insistía en un mundo “tal como la persona misma lo ve”, dado que los seres humanos tienden a representarse el campo contextual como si existiera en un “espacio” que los rodea. También el enfoque geométrico ofrecía un medio conveniente para la representación diagramática de muchas situaciones psicológicas (Bavelas 1977: 91-92).

Colega de los fundadores de la Gestalt (Wertheimer, Koffka, Köhler), Lewin fue también alumno de Carl Stumpf, y de allí los componentes fenomenológicos que todavía se perciben en la formulación de Lewin, una genuina perspectiva del actor de la cual la futura teoría de las redes sociales no tardaría en desembarazarse, pero que subsistiría bajo la forma de las redes centradas en Ego.

En 1951 Cartwright formó equipo con Frank Harary, quien tras realizar algunos trabajos sociológicos junto con él, se convertiría poco después en el padre de la moderna teoría de grafos. Esta teoría había sido formulada por el húngaro Dénes König (1931) en una Budapest atribulada por el nazismo, pero fueron Cartwright y Harary (1956) quienes le dieron genuina dimensión sociológica. Con ello su propia sociología pasó de la idea de equilibrio cognitivo a nivel individual a la de equilibrio interpersonal en grupos; a partir de allí fue casi natural que se elaboraran poderosos modelos de cohesión grupal, presión social, cooperación, poder y liderazgo. Dénes König [1884-1944] fue, incidentalmente, el maestro de Paul Erdös. En la línea de König, Harary impulsó no sólo la teoría de grafos dentro del ARS, sino que promovió las matrices (y por ende el álgebra de grupos) como forma de estudiar las relaciones sociales. Hoy en día las estructuras matriciales constituyen la forma primaria de notación de las redes sociales, la materia prima sobre la que operan el análisis y la representación gráfica.

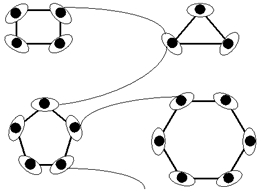

De autores como Moreno, Bavelas y Cartwright, así como de las notaciones gráficas de los matemáticos, se derivó la notación que comúnmente se utiliza en teoría de redes sociales. Esta notación es harto más simple que otras convenciones gráficas, como los diagramas de UML, la notación de Forrester, los grafos existenciales o las redes de Petri. Ni siquiera los diagramas de parentesco que los antropólogos memoriosos tal vez recuerden y de las que hablaré luego (no muy bien) eran tan transparentes. Casi se diría que en análisis de redes hay sólo dos clases primarias de entidades (nodos y conexiones) y que cada autor bien puede utilizar los indicadores diacríticos de tipo, peso o direccionalidad que le convenga cuando se lo requiera.

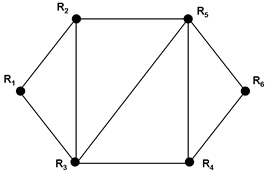

Figura 8 – Tipos de redes (grafos) – Basado en Newman (2003: 4)

La figura 8 muestra (a) un grafo no dirigido con un solo tipo de vértice y una sola clase de unión, (b) una red con cierto número de tipos y vínculos, (c) una red con diversos pesos de nodos y nexos y (d) un grafo orientado. La versatilidad expresiva y la naturaleza básicamente combinatoria de los grafos les viene de su generalidad. Como decía J. J. Sylvester hace un siglo y medio, “[l]a teoría de la ramificación es de puro co-ligamento, porque no toma en cuenta magnitud o posición; se usan líneas geométricas, pero no tienen que ver con el asunto más que las que se emplean en tablas genealógicas tienen que ver con las leyes de la procreación” (Harary 1969: 1).

De más está decir que un modelo de red puede tener información conceptual asociada tan rica como se quiera y que no todas pero unas cuantas tareas analíticas arduas y aburridas pueden hoy resolverse de un soplo (y a bajo costo) poniendo en su lugar tecnologías que ya están ofreciendo más de lo que el común de los investigadores podrá llegar a demandarles. Con ellas no se solucionan todos los problemas inherentes al fenómeno, pero sí se sientan las bases para comenzar a sacar unas cuantas conclusiones que se siguen de la forma en que los hemos planteado y para establecer procedimientos correctivos cuando las tácticas de elicitación o de resolución se manifiestan inadecuadas.

Consecuencia n° 3: El desafío que surge de este estado de cosas es que, después de una larga siesta interpretativa y posmoderna, al fin tenemos entre manos un enorme paquete de nuevas técnicas susceptibles de ser comunicadas, enseñadas y aprendidas. Como muy pocos, este paquete se ha convertido en un objeto óptimo de reflexión e intercambio. Se trata de técnicas que crean hábito, y de las que quienes las han probado con algún grado de éxito no encuentran fácil desembarazarse. Con esta idea en mente, cabe preguntarse si, olvidado ya hace décadas el mal llamado método genealógico, los antropólogos de hoy dominan alguna técnica disciplinaria distintiva. Invito a revisar, incidentalmente, la totalidad de las epistemologías de la complejidad de Edgar Morin o de Fritjof Capra para comprobar que en ninguna de ellas se promueve técnica alguna.

El corolario que podríamos derivar de este desafío es preguntarse hasta qué punto es razonable que existan teorías que no engendren directa o indirectamente alguna clase de instrumentos, alguna heurística positiva. Esta esterilidad se ha visto antes, por cierto, no sólo en el mundo humanístico sino en la teoría de catástrofes y (dejando a un lado la metodología de Forrester) en la teoría general de sistemas. Pero la situación de vaciamiento ténico en antropología se ha tornado particularmente aguda. Cuando Roy D’Andrade (2000) realizó hace poco un balance de la situación, encontró que los antropólogos ya no están aprendiendo técnicas en su formación académica y que algunas teorías hostiles a las técnicas que se auguraban fructuosas resultaron no serlo. En este sentido, la metáfora de las redes puede re-pensarse como el asiento de un conjunto de técnicas y herramientas que con todas las salvedades del caso permiten poner a prueba su propia pretensión de fecundidad.

6 – Redes aleatorias: Posibilidades y límites del azar

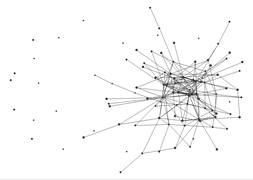

Más allá de los avances en teoría de redes propiamente sociales, desde la década de 1950 la teoría matemática de redes experimentó un crecimiento sostenido merced a los trabajos de dos matemáticos húngaros, Paul Erdös [1913-1996] y Alfred Rényi, en contemporaneidad con el hoy olvidado E. N. Gilbert (1959) y con Austin, Fagen, Penney y Riordan (1959). Dado que cuando se trabaja con elementos reticulares, incluso con algunos muy modestos, los problemas se vuelven rápidamente intratables, Erdös y Rényi propusieron considerar modelos probabilísticos, esto es, redes estructuradas estocásticamente, llamadas desde entonces ER por las iniciales de los autores (Erdös 1973: 569). Las “diversas propiedades monótonas” descubiertas en estos modelos son numerosas, pero una de ellas demanda en especial nuestra atención.

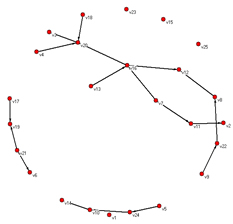

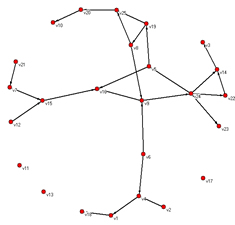

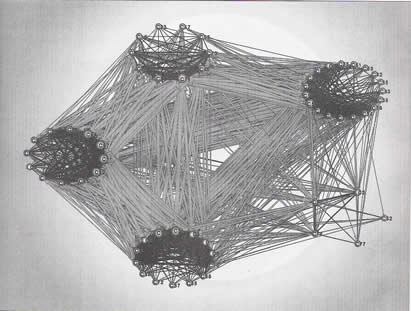

Me refiero a lo que en la ulterior teoría de la complejidad se ha dado en llamar una singularidad, catástrofe o transición de fase, aunque nuestros autores nunca usaron esos términos. Erdös y Rényi encontraron que cuando el promedio de conectividad de los nodos de una red salta de menos de uno a uno, se pasa de un estado en el cual hay varias redes inconexas a otro estado en el cual se tiene una sola gran red. La figura 9 muestra un ejemplo de red aleatoria de 25 nodos con 18 vínculos contra una del mismo número de nodos y 25 vínculos; en el segundo caso, aunque quedan algunos elementos fuera de la red, la red misma es totalmente conexa, y hay una sola red en el conjunto. Emerge lo que se ha dado en llamar un “componente gigante” (Bollobás y Riordan 2003: 4). La forma de representación escogida de este componente (en el programa Pajek) es un grafo bidimensional en función de la energía según el método propuesto por Thomas Fruchterman y Edward Reingold. Después volveré sobre esta cuestión.

Figura 9 – Redes aleatorias, inconexa y conexa

Si bien hoy se sabe que en la vida real las redes raras veces poseen la estructura y la dinámica aleatoria de los modelos ER, éstos sirvieron para revelar que en las matemáticas reticulares suceden cosas tales como transiciones abruptas y existen valores tales como puntos críticos que volverán a presentarse en otras clases de redes y en otros universos de fenómenos. El punto crítico es un umbral bajo el cual casi ningún grafo y por encima del cual casi todos los grafos exhiben una propiedad determinada (Diestel 2000: 241). Las transiciones abruptas de los grafos ER se han imaginado análogas a los eventos rápidos de especiación o cladogénesis en las teorías del equilibrio puntuado, un tema apasionante pero demasiado polémico y complejo para tratar aquí. En aquellos años todavía no se hablaba de estas cosas y la súbita demostración de la emergencia de propiedades distintas mediante la evolución monótona de propiedades fue una sorpresa mayor.

Es un poco sorprendente que tomara más de dos décadas y media darse cuenta de que cada propiedad de incremento monótono en los grafos posee una función de umbral. De hecho, mucho más que eso es verdad: cada propiedad de incremento monótono de los conjuntos, y por ende cada propiedad de incremento monótono de los grafos rotulados, posee una función de umbral. [...] De hecho, Erdös y Rényi no hablaban de transición de fase sino de la aparición súbita de un componente gigante. Sin embargo hoy, unos cuarenta años más tarde, vemos que esta bella y sorprendente propiedad de los grafos aleatorios pertenece claramente a una gran familia de fenómenos encontrados en la teoría de la probabilidad y en la física estadística. En particular, es precisamente en este punto que la teoría de Erdös y Rényi de los grafos aleatorios y la teoría de la percolación entran en estrecho contacto (Bollobás 2002: 100, 104).

Llama la atención que libros austeros plagados de ecuaciones, teoremas, lemmas y corolarios saluden el hallazgo de la transición de fase y su misma naturaleza con palabras alborozadas: un hallazgo sensacional, un espectacular período en la evolución del grafo aleatorio, un fenómeno intrigante, una apasionante época (Janson y otros 2000: 103).

El camino para profundizar en estas cuestiones es árido y empinado. La literatura técnica básica sobre redes ER comprende tres de los ocho artículos antológicos de Erdös y Rényi (“Sobre grafos aleatorios I” de 1959, “Sobre la evolución de los grafos aleatorios”7 de 1960 y “Sobre la fuerza y conectividad de los grafos aleatorios” de 1961) que se encuentran en The art of counting (Erdös 1973: 561-617); son ensayos tan densos y ricos que no pocos matemáticos epigonales han hecho carrera con su interpretación. El libro más completo sobre redes aleatorias, de lectura apenas un poco menos prohibitiva, sigue siendo Random graphs de Béla Bollobás (2001). Más accesible y con más sostenida reflexión epistemológica se presenta el artículo “The Erdös-Rényi theory of random graphs” del mismo Bollobás (2002), incluido en el segundo volumen de la compilación de Gábor Halász y otros autores sobre las matemáticas de Erdös. Un volumen por momentos inteligible para científicos sociales es el de Svante Janson, Tomasz Łukzac y Andrzej Rucinski (2000).

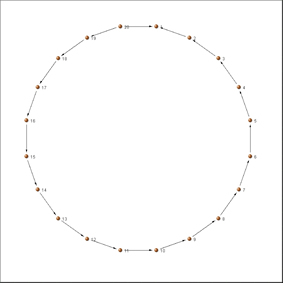

Una capacidad poco estudiada de las redes y los grafos es su utilidad para el estudio de ritmos bajo un riguroso modelo matemático. Aunque ni los músicos ni los matemáticos han elaborado seriamente el asunto, las redes (los grafos cíclicos, en rigor) son de aplicación inmediata en el análisis y la síntesis del ritmo. Ejemplo de ello son los estudios de Godfried Toussaint (2005), de la Universidad McGill en Montréal, sobre la geometría reticular del ritmo. Paul Erdös (1989), por ejemplo, define como grafos homométricos a aquellos grafos no congruentes cuyos multiconjuntos de las distancias entre pares sean iguales. El problema con las matemáticas es que se refieren a estructuras abstractas y no a las estructuras de la música en particular. Pero ¿qué sucede si aplicamos al modelo una interpretación musical?

Figura 10 – Congas homométricas

La figura 10 ilustra los ritmos de conga alta y conga baja, respectivamente, de manera que se puede apreciar su homometría: la suma de los grados de separación de sus acentos y de sus diagonales es igual en ambos casos, ocho y seis respectivamente. Con un programa como Rhythmic Wheels de Ron Eglash, se pueden escuchar los ritmos al cabo de un instante. Aunque el patrón de acentuación es distinto y ni uno solo de sus acentos coincide, ambas variantes se perciben como congas. Mientras se mantengan cuatro nodos y el mismo régimen homométrico habrá una instancia del mismo baile. Es seguro que aparte de las que se muestran en la figura hay otras posibilidades, que dejo al lector buscar. El genio de Erdös y su capacidad de encontrar pautas complejas más allá de la intuición nos permiten comprender un patrón oculto que ni el mejor informante nos habría podido revelar jamás. Rara vez se tuvo antes un modelo de análisis rítmico de semejante elegancia y simplicidad.

Incidentalmente, una de las hazañas intelectuales más impactantes de Erdös y Rényi fue su exquisita demostración de la posibilidad de métodos probabilísticos de complejidad moderada (media, varianza, expectativa, principio de inclusión-exclusión y desigualdad de Chebyshev) en la prueba de teoremas deterministas que nada parecían tener que ver con el azar. Aunque no fueron los primeros en examinar las propiedades estadísticas de los grafos, pues el pionero parece haber sido Anatol Rapoport (1957), ellos introdujeron poderosas herramientas de la teoría de la probabilidad en lo que hasta entonces se intentaba resolver mediante recursos de combinatoria enumerativa, acaso un eufemismo para designar el ensayo y error. Hoy en día los métodos en ese renglón son mucho más refinados e incluyen la desigualdad de martingala de Doob, el método Stein-Chen, transformas discretas de Fourier, métodos espectrales, cadenas de Markov de mezcla rápida, desigualdad de Azuma-Heoffding, desigualdades isoperimétricas y muchos más que sería arduo detallar o explicar de qué se tratan, asunto que dejo librado a la inquietud del lector (véase Bollobás 2002: 123).

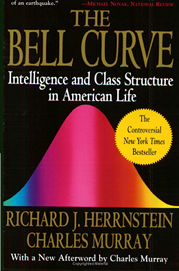

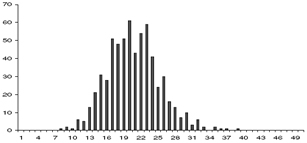

Figura 11 – Campana de Gauss y “curva de Bell”

Un aspecto importante de las redes aleatorias es que ellas presuponen distribuciones normales o Gaussianas (para mediciones continuas), o distribuciones de Poisson (para mediciones discretas)8. Una forma más adecuada de expresar esto es decir que que la distribución de grados de un grafo aleatorio resulta bien aproximado por distribuciones de esta clase. Una distribución normal característica es, por ejemplo, la de las estaturas de las personas. La clase se caracteriza por mapear en un gráfico de distribución de funciones como una curva en forma de campana, conocida como campana de Gauss, que es lo que se ve a la izquierda en la ilustración de la figura 11. La imagen de la derecha corresponde a la portada de uno de los libros más funestos sobre la presunta distribución normal del aún más presunto coeficiente intelectual, monstruosamente traducido como la “curva de Bell” (Herrnstein y Murray 1994).9 El libro no se refiere a estaturas sino a inteligencia, medida en función de un coeficiente (el de Pearson, el IQ o lo que fuere) que resulta de la unificación de numerosas medidas de escalas disímiles y dependientes de contexto y que presupone correlación positiva entre todas las capacidades intelectuales.

A lo que voy es a que una distribución normal presenta una curva en forma de campana cuyo pico coincide con la media y la mediana: una estatura o IQ “normal” es, en este contexto, la estatura o IQ más común en una población; los “normales” son mayoría, como su nombre lo indica. “Todas las distribuciones son normales”, reza el mito: lo mismo me dijo alguna vez el arqueólogo Hugo Yacobaccio cuando todavía no se sabía muy bien que eso (que depende de cómo se construye la muestra y cómo se establecen las escalas) es técnicamente inexacto. La preceptiva estadística de las ciencias sociales presupone erróneamente que esta clase de distribución es dominante; el uso de ese formuleo out of the box para tratar muestras que poseen distribuciones impropias involucra una grave distorsión, comenzando por las mismas operaciones de muestreo. Después volveré sobre estas cuestiones.

Es preciso hacer notar una característica de esa distribución: como puede verse en ambas puntas de la curva, siempre hay muy pocos individuos altísimos y muy pocos también de bajísima estatura, o poquísimos genios y gente de poca inteligencia (o como se los llame). La diferencia entre los ejemplares extremos y el pico sería de menguada magnitud: cuatro o cinco órdenes como mucho, jamás del orden de los miles o los millones (Sornette 2006: 94). Dicho de una forma algo más rigurosa, aún en el extremo de aleatoriedad absoluta de una ley gaussiana, las desviaciones de la media mayores a unas pocas desviaciones estándar son muy raras, como si hubiera límites precisos a los grados de libertad del mismo azar. Desviaciones mayores a 5, por ejemplo, nunca se ven en la práctica. Es absolutamente obvio que una entidad caracterizada por este constreñimiento refleja muy pocas características de la vida real.

No hay que ponerse en contra de Erdös y Rényi para defender tal extremo. En uno de sus artículos canónicos ellos dicen:

La evolución de los grafos aleatorios puede considerarse un modelo (más bien simplificado) de la evolución de ciertas redes reales de comunicación, p. ej. la red del ferrocarril o la red eléctrica de un país o de alguna otra unidad, o el crecimiento de estructuras de materia inorgánica u orgánica, o incluso el desarrollo de relaciones sociales. Por supuesto, si uno pretende describir tal situación real, nuestro modelo de grafo aleatorio debe reemplazarse por un modelo más complicado pero más realista (Erdös 1973: 344).

Esta afirmación, incrustada en una de los documentos más circunspectos y refinados de prueba matemática, enseña mucho, a su manera, sobre el carácter, los alcances y los límites del modelado, y sobre la conexión necesaria entre un problema y sus posibles soluciones.

Consecuencia n° 4: La lección epistemológica a destilar de estos desarrollos no tiene tanto que ver con el hallazgo sorprendente del umbral de percolación, sino más bien con la noción de tratabilidad, dado que las primeras redes interesantes de la historia se propusieron no porque la naturaleza o la sociedad fueran así, sino porque una red aleatoria no es realista pero es tratable. Vaya concepto. Con todo su espíritu crítico, la antropología, con los posmodernos al frente, se las ingenia para eludir este asunto formidable10. Como si estuvieran escenificando una parodia popperiana, los hermeneutas interpretan y los posmodernos deconstruyen lo que se les ponga por delante de manera absolutamente asertiva sin encontrar nunca límites o impedimentos. Problemas cuya trama (como la del análisis estructural del mito) es órdenes de magnitud más compleja que la Conjetura del Mapa de los Cuatro Colores o que el dilema del Vendedor Viajero, que han sido exasperantemente evasivos para los mejores matemáticos, son atacados por los antropólogos sin casi pensar, sin un solo esfuerzo riguroso de definiciones, sin ningún consenso, con teorías maquinadas en soledad en una noche de insomnio. Pero si trabajamos nuestro material más responsablemente, ¿cómo podemos saber si un problema es tratable, o si es un problema bien formado en primer lugar? Demasiado a menudo el antropólogo presupone que la teoría y el aparato metodológico con que cuenta son suficientes para el abordaje de cualquier problema, sin reflexionar sobre dos cuestiones esenciales: primero que nada, definir qué es un problema, y segundo, determinar que se trate de un problema susceptible de alguna clase de tratamiento en función de la teoría, el método y las técnicas que se es capaz de poner en acción.

A diferencia de lo que suponen complejólogos discursivos como Fritjof Capra y Edgar Morin, en este campo del conocimiento la reflexión sobre la tratabilidad nada tiene que ver con los teoremas de Kurt Gödel, los cuales, además de haber sido groseramente malinterpretados y generalizados más allá de ciertas problemáticas de autorreferencia de la aritmética de Peano, tienen muy poco que decir sobre teoría de grafos, métodos probabilísticos, álgebra lineal o su área de influencia (Franzén 2005). En este campo hay multitud de dilemas, pero no precisamente éstos.

De treinta años a esta parte, la tratabilidad tiene que ver más bien con la definición de problemas susceptibles (o no) de ser resueltos en tiempo polinómico, lo que ahora se conoce como la problemática de la NP-completitud (Garey y Johnson 1979). Respecto de esta cuestión conviene precisar la terminología. Por empezar, se dice que un problema de decisión pertenece a la clase de complejidad NP si no se conoce una máquina de Turing11 no determinista que pueda resolverlo en tiempo polinómico. Un problema de decisión es NP-duro si cada problema de decisión en NP se puede reducir a él mediante una reducción polinómica de muchos a uno. Los problemas que están en NP y en NP-duros se llaman NP-completos. Reducir significa proporcionar una transformación constructiva que mapee una instancia del primer problema en una instancia equivalente del segundo. Esta transformación brinda los métodos para convertir cualquier algoritmo que resuelve el segundo problema en el correspondiente algoritmo para resolver el segundo (Brandes y Erlebach 2005: 12-13).

Para muchos problemas, en efecto, no existe un algoritmo predefinido que facilite su resolución en un tiempo razonable. Pero demostrar que un problema es inherentemente intratable (o NP-completo) es casi tan complicado como encontrar un algoritmo eficiente. En la práctica, la solución a este dilema no es tanto hallar la receta algorítmica perfecta, sino probar que el problema que se tiene entre manos califica como NP-completo, o sea “exactamente igual de duro” que otros que han atormentado a los especialistas por años.